L’intelligence artificielle et Google : les applications de l’IA dans la recherche

C'est en 2015 que Google a annoncé l'introduction du premier système d'intelligence artificielle appliqué à la recherche, à savoir RankBrain, et ces dernières années, le travail technologique s'est poursuivi, notamment pour améliorer la compréhension du langage et, par conséquent, pour fournir dans les SERP des résultats de recherche plus proches des besoins réels des personnes, comme nous l'avons rapporté il y a quelques jours en présentant les derniers développements de LaMDA. Aujourd'hui, c'est Google lui-même qui fait le point sur l'état de cette évolution et partage des informations sur la manière dont l'IA appliquée à la recherche se traduit par des résultats pertinents, et donc où et comment ces systèmes sont réellement utilisés.

L’intelligence artificielle dans la recherche Google

C'est directement Pandu Nayak, membre de Google et vice-président de la recherche, qui décrit dans un article approfondi paru dans The Keyword "comment l'IA fournit d'excellents résultats de recherche", en aidant Google à comprendre ce que l'utilisateur recherche grâce à une meilleure compréhension du langage.

Avant 2015 et en tout cas avant de disposer d'une IA avancée, les systèmes de Google "cherchaient simplement les mots correspondants", se souvient Nayak, qui cite notamment le cas des fautes d'orthographe : en cherchant pziza, "à moins qu'il n'existe une page avec cette faute d'orthographe particulière, nous devions probablement répéter la recherche avec l'orthographe correcte pour trouver l'information qui nous intéressait". Au fil du temps, cependant, Google a appris à coder des algorithmes pour trouver des classes de modèles, telles que les fautes d'orthographe populaires ou les fautes de frappe potentielles à partir de touches proches. Aujourd'hui, grâce à un apprentissage automatique avancé, ses systèmes peuvent reconnaître de manière plus intuitive si un mot ne semble pas correct et suggérer une correction éventuelle.

Ces améliorations apportées par l'IA aux systèmes de recherche leur permettent d'affiner constamment leur compréhension de ce que l'utilisateur recherche, un facteur crucial compte tenu du fait que "le monde et les curiosités des gens évoluent constamment", "15 % des recherches que nous voyons chaque jour étant entièrement nouvelles".

Les applications réelles des systèmes d'IA

Dans les mêmes jours, un article de Barry Schwartz consacré à ce sujet est également paru, dans lequel il rapporte les informations fournies par le porte parole Danny Sullivan, qui révèle que - en résumé - il y a quatre technologies actuellement en fonctionnement dans le système de recherche.

Pour être précis, RankBrain, la correspondance neuronale et BERT sont utilisés dans le système de classement de Google pour de nombreuses requêtes, si ce n'est la plupart, et tentent de comprendre le langage de la requête et le contenu qu'ils classent. Et puis il y a le MUM, qui pour l'instant n'est pas utilisé à des fins de classement, mais uniquement pour nommer les vaccins COVID et alimenter les sujets connexes dans les résultats vidéo.

Quelles applications d’IA fonctionnent sur Google ?

Comme l'explique Nayak, il ne faut pas penser qu'une technologie plus moderne met nécessairement à la retraite l'ancienne : Google a développé des centaines d'algorithmes au fil des ans, toujours dans le but de fournir des résultats de recherche pertinents, et utilise aujourd'hui des centaines d'algorithmes et de modèles d'apprentissage automatique qui fonctionnent bien ensemble, anciens et nouveaux. En effet, "chaque algorithme et modèle a un rôle spécialisé et est activé à différents moments et dans des combinaisons distinctes pour aider à fournir les résultats les plus utiles", même si, inévitablement, certains des systèmes les plus avancés jouent un rôle plus important que d'autres, comme les quatre mentionnés dans l'article :

1. RankBrain : un système de classement plus intelligent

Cela commence comme mentionné avec RankBrain, le premier système d'apprentissage profond appliqué à la recherche. À l'époque, dit Nayak, "c'était révolutionnaire non seulement parce que c'était notre premier système d'intelligence artificielle, mais aussi parce qu'il nous a aidés à comprendre comment les mots se rapportent à des concepts dans le monde réel", ce qui est instinctif pour les humains, mais constitue un défi complexe pour un ordinateur.

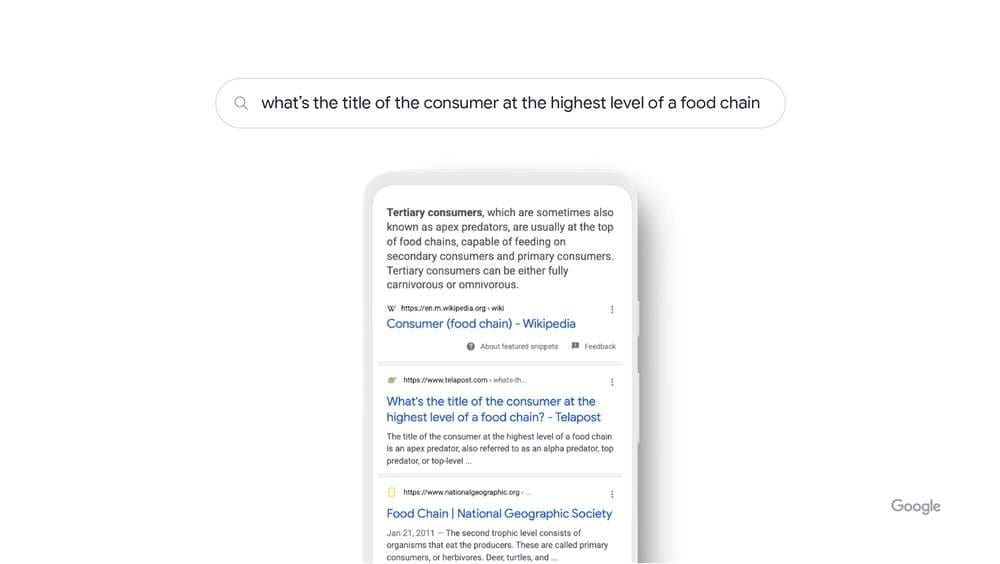

Pour expliquer le fonctionnement pratique de ce système (qui peut prendre une requête large et mieux définir la manière dont cette requête se rapporte à des concepts du monde réel), Nayak donne l'exemple de la recherche "quel est le titre du consommateur au plus haut niveau d'une chaîne alimentaire" : Les systèmes de Google apprennent en voyant sur diverses pages ces mots que le concept de chaîne alimentaire peut être lié à des animaux, et non à des consommateurs humains ; en comprenant et en faisant correspondre ces mots à leurs concepts connexes, RankBrain comprend que l'utilisateur recherchait ce que l'on appelle communément un "prédateur suprême" et fournit donc le résultat le plus pertinent.

Comme son nom l'indique, RankBrain est utilisé pour classer ou décider du meilleur ordre pour les meilleurs résultats de recherche et, malgré son âge avancé, "continue d'être l'un des principaux systèmes d'intelligence artificielle alimentant la recherche aujourd'hui", utilisé dans de nombreuses requêtes et dans toutes les langues et régions.

2. La correspondance neuronale : un moteur de recherche sophistiqué

La correspondance neuronale - neural matching - a été la prochaine IA lancée par Google pour la recherche, initialement testée en 2018, puis étendue aux résultats de recherche locaux en 2019. Aujourd'hui, les réseaux neuronaux constituent la base de nombreux systèmes d'IA modernes, et Google avait déjà entrevu leur potentiel pour affiner sa compréhension de la relation entre les requêtes et les pages, et même évaluer les représentations plus floues des concepts dans les requêtes et les pages.

Plus précisément, la correspondance neuronale aide Google à comprendre le lien entre les requêtes et les pages en examinant l'ensemble du contenu de la requête ou de la page (et pas seulement la chaîne de mots clés) dans le contexte de cette page ou de cette requête, ce qui permet à Google d'avoir une compréhension plus large des concepts et donc d'élargir la quantité de contenu que Google est en mesure de rechercher.

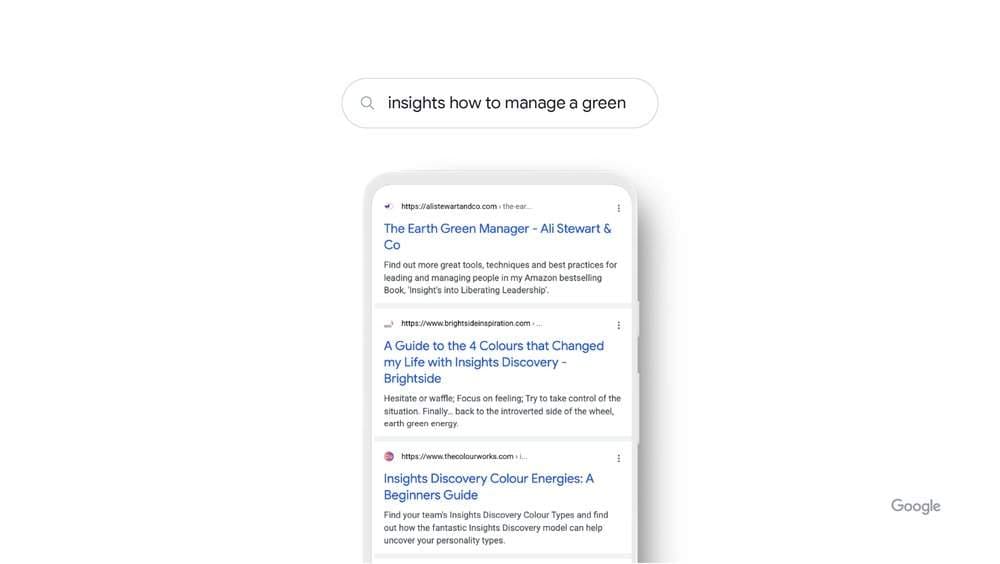

L'exemple le plus clair est celui des "conseils sur la façon de gérer un vert", qui peut sembler étrange même pour un être humain : grâce à l'appariement neuronal, Google a toutefois observé les représentations plus larges des concepts de la requête - gestion, leadership, personnalité et autres - et a déchiffré que l'utilisateur recherchait des conseils de gestion liés à un guide de personnalité populaire basé sur les couleurs.

Aujourd'hui, la correspondance neuronale fait partie de l'algorithme de classement, est utilisée dans de nombreuses requêtes - si ce n'est la plupart - pour toutes les langues, dans toutes les régions et dans la plupart des secteurs, et aide spécifiquement Google à classer les résultats de recherche : la compréhension accrue des concepts plus larges représentés dans une requête ou sur une page permet de "ratisser large lorsque nous parcourons notre index à la recherche de contenus susceptibles d'être pertinents pour votre requête". La correspondance joue donc un rôle essentiel dans la manière dont Google extrait les documents pertinents d'un flux d'informations énorme et en constante évolution.

3. BERT - un modèle pour la compréhension du sens et du contexte

C'est en 2019 qu'a fait ses débuts BERT (Bidirectional Encoder Representations form Transformers), ou plus simplement BERT, une technologie basée sur les réseaux neuronaux pour le pré-entraînement du traitement du langage naturel, qui a représenté un énorme changement dans la compréhension du langage naturel, en aidant Google à comprendre comment les combinaisons de mots expriment différentes significations et intentions.

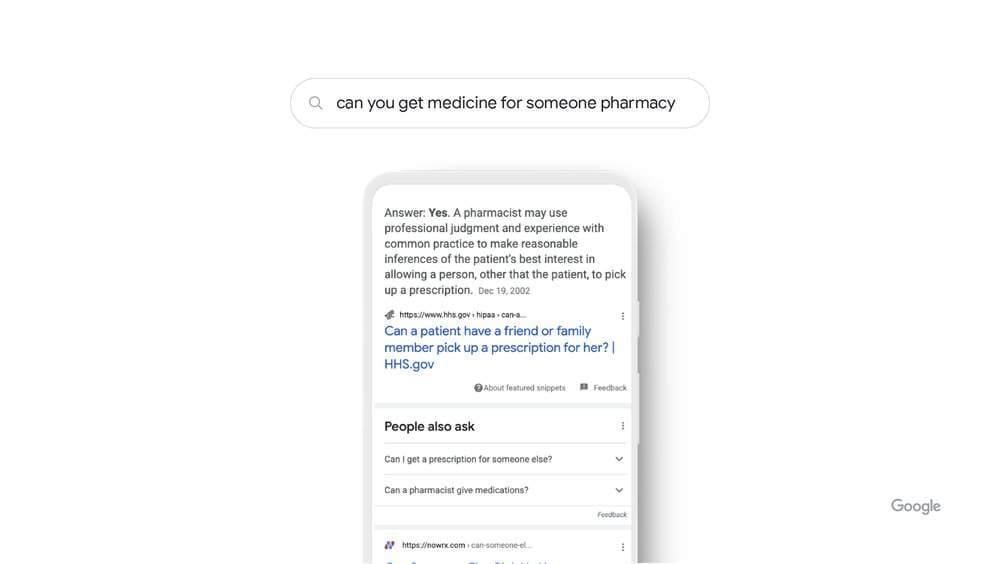

Plutôt que de se contenter de rechercher du contenu correspondant à des mots individuels, BERT comprend comment une combinaison de mots exprime une idée complexe, des significations et des intentions différentes, comprend les mots d'une séquence et la manière dont ils sont liés les uns aux autres, et examine tous les mots de la requête, même ceux qui sont apparemment insignifiants, mais qui "peuvent avoir de grandes significations". En pratique, cela permet à Google de comprendre comment les mots peuvent modifier le sens des requêtes lorsqu'ils sont utilisés dans une séquence particulière.

En lançant la requête "pouvez-vous prendre des médicaments pour une pharmacie", BERT comprend que nous essayons de savoir si nous pouvons prendre des médicaments pour quelqu'un d'autre ; avant cette technologie, cependant, Google ignorait la préposition et se contentait de partager des résultats sur la façon de remplir une ordonnance (comment prendre des médicaments).

Au moment de son lancement, BERT était utilisé dans 10 % de toutes les requêtes en anglais, mais il a été étendu à d'autres langues et bientôt utilisé dans presque toutes les requêtes en anglais ; aujourd'hui, il est utilisé dans la plupart des requêtes et est supporté dans toutes les langues.

Selon Nayak, BERT excelle "dans deux des tâches les plus importantes pour fournir des résultats pertinents : le classement et la recherche". Grâce à sa compréhension complexe du langage, BERT peut classer très rapidement les documents en fonction de leur pertinence. En outre, sa formation a permis d'améliorer les systèmes existants, les rendant plus utiles pour récupérer les documents pertinents en vue de leur classement. Pourtant, BERT ne travaille jamais seul mais, comme tous les autres systèmes, fait partie d'un ensemble de technologies qui travaillent ensemble pour partager des résultats de haute qualité.

4. MUM : du langage à la compréhension de l'information

Plus récente est l'introduction de Google MUM, une technologie annoncée à la Google I/O 2021 en mai dernier et le dernier jalon de l'IA dans la recherche : mille fois plus puissant que BERT, MUM est capable à la fois de comprendre et de générer du langage (il peut donc être utilisé pour comprendre les variations de nouveaux termes et de nouvelles langues), il est entraîné dans 75 langues et pour de nombreuses tâches différentes à la fois, ce qui lui permet de développer une compréhension plus complète de l'information et de la connaissance du monde. Le MUM est également multimodal, ce qui signifie qu'il peut comprendre des informations dans de multiples modalités telles que du texte, des images et d'autres encore à l'avenir.

Par rapport aux cas précédents, Nayak souligne que le MUM n'est pas utilisé à des fins de classement dans Google Search pour le moment, et ne sert donc pas à classer et à améliorer la qualité des résultats de recherche comme le font RankBrain, le matching neuronal et les systèmes BERT.

Quoi qu'il en soit, cette technologie est compatible avec toutes les langues et toutes les régions, et Google a testé une partie de son potentiel pour améliorer les recherches d'informations sur le vaccin COVID-19 et pour générer des suggestions sur des sujets connexes dans les résultats vidéo. Une application future possible prévue par l'article est "d'offrir des moyens plus intuitifs d'effectuer des recherches en utilisant une combinaison de texte et d'images dans Google Lens", et l'utilisation progressive d'expériences basées sur le MUM dans la recherche "passera de la compréhension avancée du langage à une compréhension plus complexe et articulée des informations sur le monde".

Intelligences artificielles et mises à jour de Google

Telles sont les principales utilisations que Google fait des systèmes d'intelligence artificielle appliqués à ses SERPs, qui servent avant tout à "comprendre le langage, y compris la requête et les résultats potentiellement pertinents" et "ne sont pas conçus pour agir de manière isolée pour analyser uniquement une requête ou le contenu d'une page", mais précisément pour avoir une compréhension générale de ces deux aspects.

Et puis il y a les mises à jour de base, comme le rappelle Schwarz, les mises à jour périodiques qui servent à garantir que les résultats fournis par le moteur de recherche sont toujours pertinents et de qualité : comme l'a révélé Google, en plus des trois grands mécanismes d'IA appliqués à la recherche (RankBrain, matching neuronal et BERT), il existe en fait "d'autres éléments d'intelligence artificielle qui peuvent influencer les mises les core updates" sur des aspects qui ne concernent pas l'activité de ces trois systèmes, et il y a donc différents types d'IA à l'œuvre simultanément.

En outre, il existe un monde en dehors de la recherche - recherche locale, les images, achats et autres verticaux de l'écosystème de Big G - où d'autres types de technologies distinctes et spécialisées sont utilisées.

Ce que ces systèmes d’IA signifient pour le référencement naturel

Le fait de savoir que l'intelligence artificielle est de plus en plus au cœur de Google et de la recherche ne doit pas nous effrayer quant à l'avenir possible du référencement naturel - et pas seulement parce que John Mueller nous a déjà rassuré dans un passé pas si lointain que " le référencement ne deviendra pas obsolète malgré l'IA et l'apprentissage automatique ".

En fait, ces systèmes servent principalement à améliorer la façon dont Google lui-même comprend les requêtes et le contenu des sites pour une correspondance parfaite avec l'intention de l'utilisateur et, en fin de compte, à rapprocher le moteur de recherche du même langage que nous. Cela devrait effectivement aider notre travail dans la création de contenu, en rappelant le premier conseil pratique pour la rédaction SEO, c'est-à-dire "l'écriture pour les humains": si nous interceptons l'intention de recherche sous-jacente à la requête et si les gens comprennent ce que nous écrivons, même les algorithmes et les intelligences artificielles le feront le comprendre et récompensera les pages avec le bon classement.

Ainsi, même s'il n'existe pas de techniques d'optimisation du référencement pour BERT ou les autres IA, tout le travail classique que nous faisons pour améliorer nos sites et nos pages, tant au niveau du contenu que sur le plan technique, reste valable.