À la Google I/O 2022, les dernières nouvelles sur la recherche (et le référencement)

Beaucoup, beaucoup d'annonces liées aux domaines illimités dans lesquels la présence de Big G se fait sentir - le fameux écosystème Google, qui couvre pratiquement tous les aspects de la vie, numérique et autre, comme nous pouvons le voir dans cette liste de 100 choses annoncées ! - mais rien de particulièrement surprenant ou révolutionnaire pour le système de recherche et donc pour le référencement. Alors que le rideau est tombé sur la Google I/O 2022, nous pouvons faire un tour d'horizon de l'événement de cette année et des éventuelles nouveautés qui arriveront sur le moteur de recherche, afin de pouvoir éventuellement nous préparer et préparer nos plans pour les intercepter.

Google I/O 2022, discours de Sundar Pichai

Il était peut-être impossible que pour le moteur de recherche il y ait déjà une autre révolution après celle prévue à Google I/O 2021, quand la révélation de Google MUM et des applications des systèmes d'intelligence artificielle (aussi) au système de recherche avait attiré tous les projecteurs sur le produit le plus célèbre de Big G, mais probablement personne ne s'attendait à ce que la recherche soit si peu présente dans l'événement dédié aux webmasters et aux développeurs web qui représente une véritable vitrine pour la société californienne (et qui doit son nom aux initiales de Input et Output).

En tout cas, les points d'intérêt n'ont pas manqué au sein de la Google I/O 2022, qui concernent (encore) les applications de la technologie à la recherche afin de pouvoir garantir ce qui, comme le confirme Sundar Pichai, PDG de Google et d'Alphabet, reste la mission fondamentale de Google, aujourd'hui comme il y a environ 24 ans : "organiser les informations du monde et les rendre universellement accessibles et utiles".

L'information et la connaissance au cœur du processus

La technologie joue un rôle central pour conduire Mountain View vers cet objectif et "les progrès que nous avons réalisés sont dus à nos années d'investissement dans les technologies de pointe, de l'IA à l'infrastructure technique qui alimente tout", déclare M. Pichai dans son discours d'introduction.

La société poursuit "cette mission de deux manières : en approfondissant notre compréhension de l'information, afin de la transformer en connaissances, et en améliorant l'état de l'informatique, afin de faciliter l'accès aux connaissances, quels que soient l'endroit et l'utilisateur".

M. Pichai poursuit en relatant certaines des dernières réalisations du moteur de recherche, qui "pendant la pandémie, s'est attaché, entre autres, à fournir des informations précises pour aider les gens à rester en bonne santé" (et au cours de l'année écoulée, les gens ont utilisé Google Search et Maps près de deux milliards de fois pour trouver un endroit où ils pouvaient se faire vacciner contre le COVID), a développé "la technologie de prévision des inondations pour aider les gens à rester en sécurité face aux catastrophes naturelles" (et pendant la saison de la mousson de l'année dernière, ces alertes aux inondations ont alerté plus de 23 millions de personnes en Inde et au Bangladesh, permettant l'évacuation en temps voulu de centaines de milliers de personnes), a collaboré avec le gouvernement ukrainien "pour déployer rapidement des alertes aux raids aériens" (en envoyant des centaines de millions d'alertes pour aider les gens à se mettre en sécurité).

Ce qui s'annonce pour la recherche

M. Pichai a également dévoilé rapidement certaines des fonctionnalités et mises à niveau innovantes qui seront apportées à Google Search dans le monde entier. Il a notamment cité l'ajout de 24 langues supplémentaires à Google Translate (le système de traduction en temps réel qui "témoigne de la manière dont la connaissance et l'informatique s'associent pour améliorer la vie des gens") et les améliorations continues apportées à l'IA conversationnelle.

Il s'agit de la version 2.0 de LaMDA de Google, le modèle de langage génératif pour les applications conversationnelles capables de converser sur n'importe quel sujet, qui devient "notre IA conversationnelle la plus avancée à ce jour".

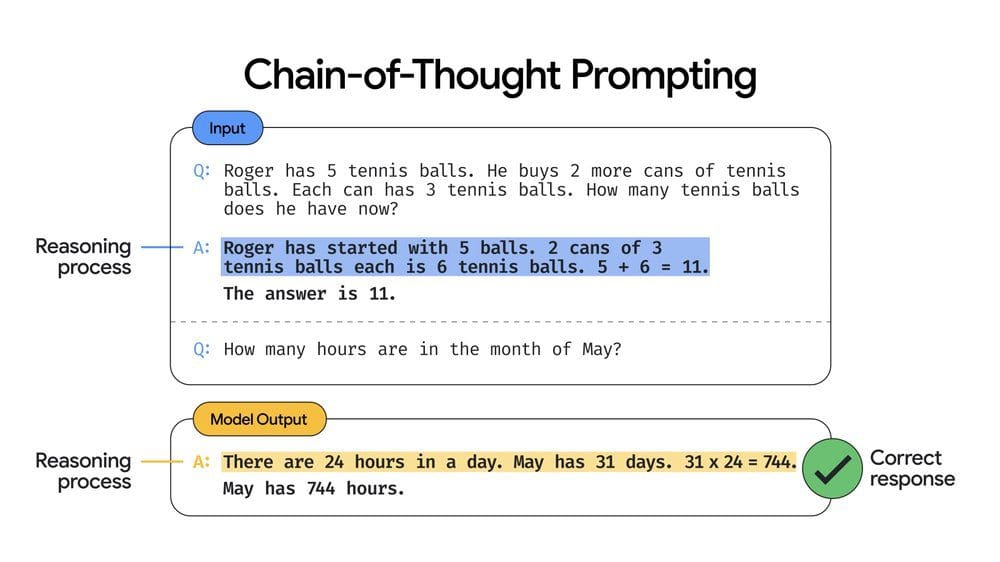

Au LaMDA 2 s'ajoute désormais le Pathways Language Model, ou PaLM en abrégé, un nouveau modèle technologique conçu pour explorer d'autres aspects du traitement du langage naturel et de l'IA : il s'agit du plus grand modèle de Google à ce jour, entraîné sur 540 milliards de paramètres, qui, selon M. Pichai, "démontre des performances révolutionnaires sur de nombreuses tâches de traitement du langage naturel, telles que la génération de code à partir d'un texte, la réponse à un problème mathématique sous forme de mots, ou même l'explication d'une blague" grâce à une technique appelée "chain-of-thought prompting", ou incitation à la chaîne de pensée, qui permet de décrire des problèmes à plusieurs étapes sous la forme d'une série d'étapes intermédiaires, et d'augmenter largement la précision de la réponse.

Enfin (en se limitant toujours aux applications de recherche et aux effets possibles sur le référencement), le PDG de Google prévoit une utilisation de plus en plus intensive de la réalité augmentée, notamment par le biais de l'application Google Lens, qui, selon les données révélées lors de l'événement, est désormais utilisée plus de 8 milliards de fois par mois dans le monde, soit pratiquement trois fois plus que l'année dernière.

Multisearch, le nouveau système de recherche autour de nous

Et c'est précisément à travers Lens que fonctionne Multisearch, qui est peut-être l'annonce la plus importante pour le segment de la recherche qui a été faite à la Google I/O 2022 (même si, en réalité, le système a déjà été présenté ces dernières semaines et qu'une nouvelle mise à jour a été mentionnée lors de l'événement).

La recherche multiple est une fonction de recherche spéciale qui, grâce à l'utilisation de l'application Lens et de l'appareil photo du smartphone, permet d'effectuer des recherches à partir de l'image encadrée, tout en ajoutant une requête textuelle supplémentaire pour affiner la recherche. Google utilise alors l'image et le texte de la requête pour afficher les résultats de la recherche visuelle.

Avec Multisearch Near Me, il y a une étape supplémentaire : il sera possible de zoomer sur ces requêtes image et texte pour rechercher des produits ou d'autres choses via la caméra, ou des résultats locaux - par exemple, pour trouver un restaurant proposant un plat spécifique.

Du point de vue de l'optimisation des moteurs de recherche, cette fonctionnalité représente une nouvelle façon pour les utilisateurs/consommateurs d'entrer en contact avec notre contenu : outre les résultats de recherche classiques sur ordinateur, les recherches sur mobile, les recherches vocales et les recherches d'images, nous devons désormais nous préoccuper de la recherche multiple, ce qui confirme également que les ressources visuelles sont déjà essentielles pour intercepter les gens et les inciter à cliquer, ce qui est encore plus important pour les entreprises locales.

Recherches intégrées d'images et de textes, y compris pour les recherches locales

Selon Prabhakar Raghavan, premier vice-président de la société, avec la recherche multiple, "nous redéfinissons une fois de plus la recherche Google, en combinant notre compréhension de tous les types d'informations (texte, voix, visuel et autres) afin que vous puissiez trouver des informations utiles sur tout ce que vous voyez, entendez et expérimentez, de la manière la plus intuitive possible".

Raghavan décrit brièvement les applications possibles de ce système qui, dans sa version Near Me, sera disponible dans le monde entier d'ici la fin de l'année en anglais et s'étendra à d'autres langues au fil du temps : "Vous pouvez utiliser une image ou une capture d'écran et ajouter 'near me' pour voir les options de restaurants ou de détaillants locaux qui ont les vêtements, les articles pour la maison et la nourriture que vous recherchez. Par exemple, poursuit-il, "supposons que vous voyez en ligne un plat coloré que vous aimeriez essayer, mais que vous ne savez pas ce qu'il contient ou comment il s'appelle : lorsque vous utilisez la fonction de recherche multiple pour trouver un plat près de chez vous, Google analyse des millions d'images et d'avis publiés sur des pages Web et par notre communauté de contributeurs Maps pour trouver des résultats sur les lieux proches qui proposent ce plat afin que vous puissiez le déguster vous-même".

Et bientôt, une autre mise à jour, appelée "exploration de scènes", permettra à Google d'améliorer la recherche visuelle en reconnaissant non seulement les objets capturés dans une seule image, mais aussi l'ensemble de la scène. Grâce à l'utilisation de la recherche multiple Multisearch, nous pourrons effectuer un panoramique à l'aide de la caméra du smartphone et obtenir instantanément des informations sur plusieurs objets dans cette vaste scène.

Cette exploration de la scène "est une étape importante dans la capacité de nos appareils à comprendre le monde comme nous le faisons" et permettra aux gens de "trouver facilement ce qu'ils recherchent", conclut le premier vice-président de Google.

Des applications annoncées pour la recherche (et pour le référencement)

Pour passer à des questions plus pratiques, voyons quelles sont les nouveautés qui affectent directement le moteur de recherche le plus utilisé au monde.

La première annonce concerne la délicate question de la vie privée : Google est sur le point d'introduire un outil spécifique dans Search pour gérer sa présence en ligne et aider chacun à contrôler facilement "si vos informations personnellement identifiables peuvent être trouvées dans les résultats de recherche, afin que vous puissiez être plus à l'aise avec votre empreinte digitale en ligne", précise Danielle Romain, VP Trust. Cet outil est nécessaire car "pour de nombreuses personnes, un élément clé pour se sentir plus en sécurité et plus privées en ligne est d'avoir plus de contrôle sur l'endroit où leurs informations sensibles et personnellement identifiables peuvent être trouvées".

Cet outil facilitera la suppression des résultats de Google contenant des informations de contact personnelles (telles que le numéro de téléphone, l'adresse du domicile ou l'adresse électronique). Il sera disponible dans l'application Google ou en cliquant sur les trois points situés à côté de chaque résultat de recherche Google. Lorsque Google recevra le rapport accompagné d'une demande de suppression, il évaluera l'ensemble du contenu de la page web pour vérifier le cas et ne pas restreindre la disponibilité d'autres informations largement utiles (par exemple, dans les articles d'actualité) et "bien sûr, la suppression des informations de contact de Google Search ne les supprime pas du Web, c'est pourquoi il peut être utile de contacter directement le site d'hébergement si vous vous sentez à l'aise pour le faire", suggère Romain.

"Une autre partie importante de la sécurité en ligne consiste à faire confiance aux informations que vous trouvez", déclare Nidhi Hebbar, chef de produit chez Google, en présentant une nouvelle mise à niveau de la fonction À propos de ce résultat : lancé en février 2021, cet outil est disponible en anglais sur les résultats de recherche individuels et sert à aider les utilisateurs à découvrir le contexte général d'un site web avant même de le visiter.

En attendant l'extension à d'autres langues - qui devrait arriver d'ici la fin de l'année, selon M. Hebbar - la fonction a été utilisée plus de 1,6 milliard de fois et débarque maintenant dans d'autres parties de l'écosystème. Concrètement, lorsque l'utilisateur consulte une page web sur l'application Google, il pourra, d'un simple toucher, voir apparaître un onglet contenant des informations sur la source, notamment une brève description, ce que le site dit de lui, et les avis des autres sur le web, de sorte que chacun dispose "des outils pour évaluer l'information où qu'il soit en ligne, et pas seulement sur la page des résultats de recherche".

En pratique, comme le montre le gif, avec cette mise à jour, nous pourrons trouver un contexte utile sur une source même si nous sommes déjà sur le site et sur n'importe quel site.

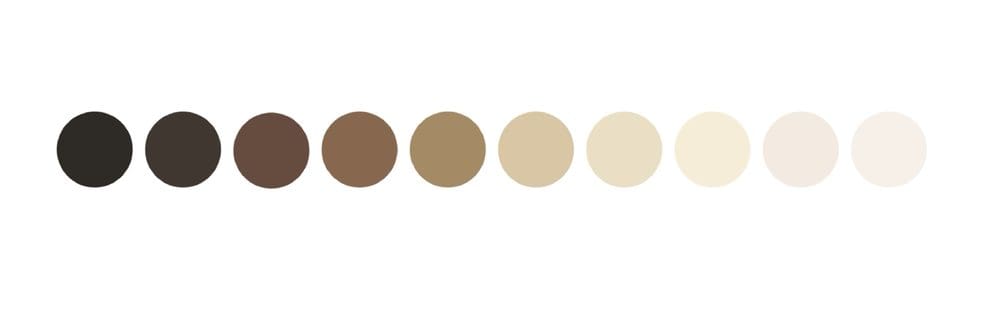

La nouvelle échelle de teinte de la peau de Search, conçue en collaboration avec le Dr Ellis Monk (professeur et sociologue à Harvard), est également intéressante car elle reflète mieux l'éventail réel des teintes de peau que l'on rencontre dans notre société. Le nouvel outil s'appelle Monk Skin Tone Scale et il s'agit en fait d'une échelle à 10 tons qui sera intégrée à divers produits Google dans les mois à venir, dans le but d'aider Big G "et l'industrie technologique dans son ensemble à créer des ensembles de données plus représentatifs afin que nous puissions former et évaluer les modèles d'IA pour l'équité, ce qui se traduit par des fonctionnalités et des produits qui fonctionnent mieux pour tout le monde, quelle que soit la couleur de la peau", comme l'explique Tulsee Doshi, chef de produit responsable de l'IA.

Plus précisément, l'échelle sera utilisée par Google pour évaluer et améliorer les modèles qui détectent les visages dans les images, mais aussi pour "permettre aux personnes de toutes origines de trouver plus facilement des résultats plus pertinents et plus utiles" dans la recherche et pour améliorer Google Photos (avec des filtres spéciaux conçus pour bien fonctionner sur toutes les carnations et évalués à l'aide de l'échelle MST).

Nous terminons par une annonce de nature encore plus fonctionnelle : bientôt, dans la section Couverture (Index) de Google Search Console, il y aura le rapport d'indexation des pages vidéo, qui montrera un résumé de toutes les pages vidéo trouvées par Google pendant le crawling et l'indexation du site web, avec les informations classiques concernant le statut des pages et la présence d'éventuelles erreurs.