Découvrons Googlebot, le robot d’exploration de Google qui analyse les sites.

Mais surtout, Googlebot est le logiciel araignée fondamental avec lequel Google est capable de scanner les pages des sites Web publics, en suivant les liens qui partent d'une page et la relient à d'autres sur le Web, et en sélectionnant ainsi les ressources qui méritent d'entrer dans l'index du moteur de recherche. En bref, ce petit robot est à la base de tout le processus d'exploration et d'indexation de Google, d'où découle son système de classement. Ce n'est donc pas une coïncidence si l'équipe du moteur de recherche a consacré plus d'attention à ce sujet : essayons de découvrir tout ce qu'il faut savoir sur Googlebot, le robot d'exploration qui a pour tâche de rechercher des sites et du contenu sur le Web pour le compte de Big G.

Qu’est-ce que Googlebot ?

Aujourd'hui, prenons donc un peu de recul par rapport aux questions liées aux pratiques d'optimisation et essayons d'expliquer brièvement ce qu'est Googlebot et comment il fonctionne, mais surtout pourquoi il est important pour un site de savoir comment Google nous regarde - en un mot, parce qu'avoir une compréhension de base du fonctionnement du crawling et de l'indexation des moteurs de recherche peut nous aider à détecter, prévenir ou résoudre les problèmes techniques de référencement et à garantir que les pages du site sont correctement accessibles aux crawlers eux-mêmes.

Le dernier en date dans l'ordre chronologique à s'intéresser à ce sujet est la mise à jour du guide officiel de Google sur Googlebot, mais le crawler avait déjà fait l'objet auparavant d'un épisode de SEO Mythbusting, la série YouTube de Martin Splitt qui, poussé par les demandes de nombreux webmasters et développeurs et par la question précise de Suz Hinton (Cloud Developer Advocate chez Microsoft, hôte de l'occasion), a poursuivi en clarifiant certaines caractéristiques de ce logiciel.

À cette occasion, Splitt avait donné une définition claire et simple de Googlebot, qui est en fait un programme qui remplit trois fonctions : la première est le crawling, l'analyse approfondie du Web à la recherche de pages et de contenus ; la deuxième est l'indexation de ces ressources, et la troisième est le "ranking", qui, cependant, "ne fait plus Googlebot", a-t-il encore précisé.

En pratique, le robot prend le contenu de l'internet, essaie de comprendre le sujet du contenu et les "matériaux" qui peuvent être offerts aux utilisateurs qui recherchent "ces choses", et détermine finalement laquelle des ressources précédemment indexées est réellement la meilleure pour cette requête spécifique à ce moment précis.

Ce que fait Googlebot et à quoi il sert

Pour aller plus loin, Googlebot est un logiciel spécial, communément appelé "araignée", "crawler" ou simplement "bot", qui parcourt le web en suivant les liens qu'il trouve dans les pages pour trouver et lire du contenu nouveau ou mis à jour et suggérer ce qui devrait être ajouté à l'index, la bibliothèque d'inventaire en constante expansion dont Google extrait directement les résultats de recherche en ligne.

Ce logiciel permet à Google de compiler plus d'un million de Go d'informations en une fraction de seconde. Ainsi, derrière son apparence mignonne - l'image officielle de Googlebot représente précisément un mignon petit robot à l'allure vivante, vaguement semblable à Wall-E, prêt à se lancer dans une quête pour trouver et indexer des connaissances dans tous les coins encore inconnus du Web - se cache une puissante machine qui scrute le Web et ajoute constamment des pages à son index.

Plus précisément, Googlebot est le nom générique de deux types de moteur d'exploration différents : un moteur d'exploration pour ordinateur de bureau qui simule un utilisateur utilisant un appareil de bureau et un moteur d'exploration mobile qui simule un utilisateur utilisant un appareil mobile. Parfois, notre site est visité par les deux versions de Googlebot (et si c'est le cas, nous pouvons identifier le sous-type de Googlebot en examinant la chaîne de l'agent utilisateur dans la requête), mais si notre site a déjà été converti en mode mobile-first sur Google, la plupart des requêtes d'exploration de Googlebot sont effectuées à l'aide du moteur mobile, tandis qu'une petite partie est effectuée à l'aide de l'araignée version ordinateur de bureau, et vice versa pour les sites qui n'ont pas encore été convertis (comme l'explique Google en fait, l'araignée minoritaire n'explore que les URL déjà explorées par le moteur majoritaire).

De plus, toujours d'un point de vue technique, Googlebot desktop et Googlebot mobile partagent cependant le même jeton de produit (jeton d'agent utilisateur) dans le fichier robots.txt, de sorte que nous ne pouvons pas cibler sélectivement Googlebot for smartphones ou Googlebot for desktops à l'aide du fichier robots.txt.

Les autres robots de Google

Googlebot est le principal robot d'exploration de Google, mais il n'est pas le seul, et il existe en effet plusieurs robots, qui ont des tâches spécifiques : par exemple, AdSense et AdsBot contrôlent la qualité des annonces, tandis que Mobile Apps Android surveille les applications Android, Googlebot-Image suit les images, Googlebot-Video les vidéos, et Googlebot-News les actualités.

Ce miroir officiel nous aide à garder un œil sur tous les visiteurs possibles (et surtout souhaités) de notre site et de nos pages :

Les caractéristiques techniques de Googlebot : une araignée perpétuelle et super rapide

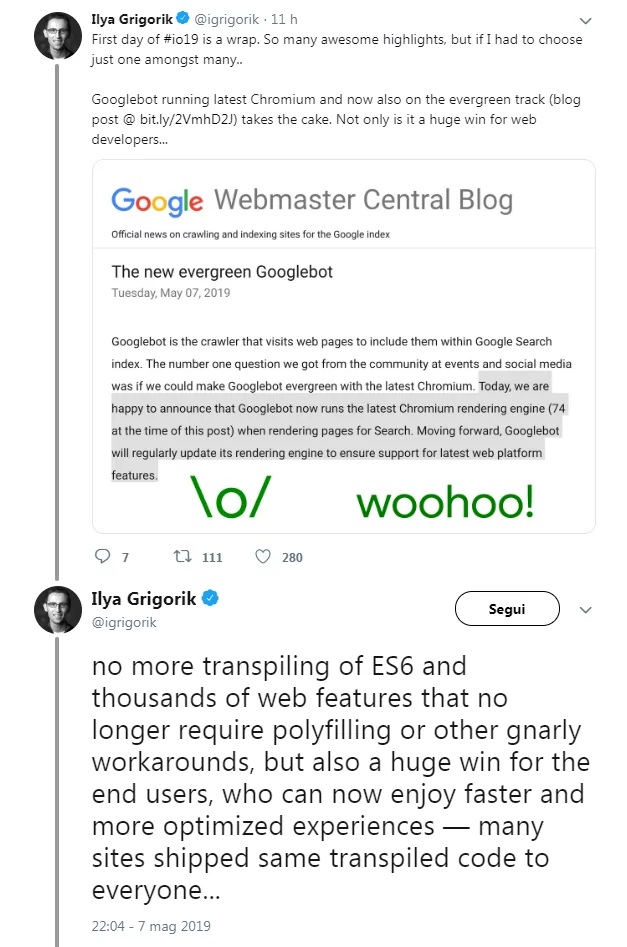

À partir de mai 2019, il y a eu une innovation technique fondamentale pour le crawler de Big G : afin d'assurer le support des plus récentes fonctionnalités des plateformes web, en effet, Googlebot est devenu evergreen et continuellement mis à jour, équipé d'un moteur capable de gérer constamment la dernière version de Chromium lors du rendu des pages web pour la Recherche.

Selon Google, cette fonction était la "demande numéro un" des participants aux événements et des communautés sur les médias sociaux en ce qui concerne les implémentations à apporter au bot. L'équipe californienne s'est donc concentrée sur la possibilité de rendre GoogleBot toujours à jour avec la dernière version de Chromium, en réalisant un travail qui a duré des années pour travailler sur l'architecture profonde de Chromium, optimiser les couches, intégrer et faire fonctionner le rendu pour la recherche, etc.

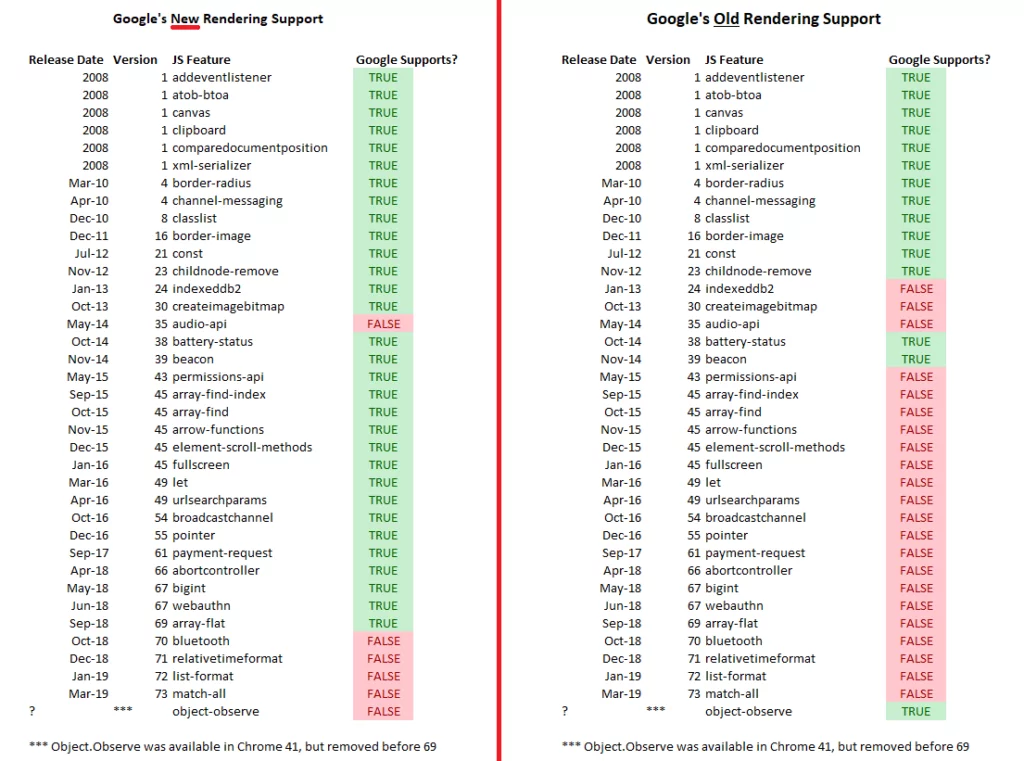

Concrètement, depuis lors, Googlebot est devenu capable de supporter plus d'un millier de nouvelles fonctionnalités, comme notamment ES6 et les nouvelles fonctionnalités JavaScript, IntersectionObserver pour le lazy-loading, et l'API Web Components v1. Google invite alors les webmasters et les développeurs à vérifier si leur site effectue un transpiling ou utilise des polyfills spécifiquement pour GoogleBot, et si oui, à évaluer si cela est encore nécessaire à la lumière du nouveau moteur, en soulignant également qu'il y a encore quelques limitations, surtout pour JavaScript.

En particulier, dans ces cas, Google doit encore scanner et rendre le JavaScript en deux étapes : d'abord GoogleBot scanne la page, puis il répète l'opération pour la rendre graphiquement (traduction littérale de rendering) dans son intégralité.

Une étape nécessaire pour moderniser l'araignée et apporter des avantages aux développeurs et aux utilisateurs finaux.

Jusqu'en mai 2019, GoogleBot avait été délibérément maintenu obsolète (pour être précis, le moteur a été testé sur Chrome v41, sorti en 2015) pour s'assurer qu'il indexait les pages web compatibles avec les anciennes versions de Chrome. Cependant, ces derniers temps, il s'était généralisé pour les sites web construits sur des frameworks modernes avec des fonctionnalités non prises en charge par Chrome 41, qui subissaient alors l'effet inverse et rencontraient des difficultés.

La décision de rendre GoogleBot et son moteur de recherche "evergreen" résout ce problème et, dans le même temps, représente une nouvelle positive pour les utilisateurs finaux, qui peuvent désormais profiter d'expériences plus rapides et plus optimisées.

Comme l'a écrit Ilya Grigorik, ingénieur en charge des performances Web chez Google, sur twitter, il n'y aura plus de " transpilage de l'ES6″ ni de " centaines de fonctionnalités Web qui ne nécessitent plus de polyfilling ou d'autres contournements complexes ", ce qui profitera également aux nombreux sites qui ont envoyé le même code transpilé à tout le monde.

Comment fonctionne le nouveau moteur Googlebot

En fait, avant même la confirmation officielle, certains experts internationaux, et en particulier Alec Bertram de DeepCrawl, avaient découvert que Google testait une version plus moderne de GoogleBot avec des fonctionnalités présentes dans Chrome v69 ou ultérieur, au lieu des traditionnelles de Chrome v41. Et Martin Splitt lui-même a confirmé le test par un tweet, dans lequel il affirme que les tests sont fréquents chez Google et sont parfois visibles.

Concrètement, la nouveauté concerne le support de certaines fonctions JavaScript par GoogleBot, qui dans la nouvelle version a été largement étendu par rapport aux versions précédentes : dans les scripts lancés par DeepCrawl et montrés sur la page, on peut saisir les différentes différences entre la version de Chrome 41 (qui, comme mentionné, était celle de base utilisée à l'époque) et la version 69 (l'une des plus actuelles en mai 2019).

Problèmes courants avec JavaScript

L'article explique également certains détails des opérations classiques d'exploration du Web : les moteurs de recherche peuvent récupérer ou télécharger le code HTML d'une page Web, en extraire le contenu et l'utiliser pour indexer et classer les pages. Avec l'évolution du développement web, les développeurs ont commencé à utiliser des JavaScript complexes côté client dans le navigateur pour rendre leurs pages plus rapides, plus légères et plus dynamiques.

Ces fonctionnalités JavaScript posent des problèmes pour l'activité classique de récupération des crawlers : pendant le téléchargement des fonctions JavaScript, ils n'effectuent aucune autre opération et ne peuvent donc pas voir le contenu ajouté à la page avec JavaScript.

C'est pourquoi les robots d'exploration des moteurs de recherche et GoogleBot se sont adaptés à ces changements, en mettant en œuvre une phase de rendu dans l'exploration après la phase de récupération, qui charge essentiellement la page explorée dans un navigateur, lui permet de charger entièrement et d'exécuter tout JavaScript, puis utilise le contenu trouvé dans la page rendue lors de l'indexation et du positionnement d'une URL.

Ce que la mise à jour de GoogleBot signifie pour les référenceurs

La dernière mise à jour de GoogleBot a eu des effets importants pour les référenceurs et les développeurs, surtout d'un point de vue pratique : le fait que Google soit capable d'afficher les pages web comme un navigateur moderne devrait donner moins de soucis quant à l'interprétation des ressources de différents types, y compris les applications web modernes, limitant l'utilisation de solutions alternatives telles que le rendu dynamique pour rendre le contenu crawlé, l'indexation et le classement sur Google.

Classement Google et Googlebot, quelle est la relation ?

Pour en revenir à la vidéo de Splitt (et notamment à la mention du classement), le défenseur des développeurs de l'équipe chargée des relations avec les moteurs de recherche de Google explique plus en détail le concept de Googlebot et de classement, en précisant que l'activité de classement de Google est informée par Googlebot, mais ne fait pas partie de ce dernier.

Cela signifie donc que pendant la phase d'indexation, le programme s'assure que le contenu crawlé est utile pour le moteur de recherche et son algorithme de classement, qui utilise, comme nous l'avons dit à plusieurs reprises, des critères spécifiques pour classer les pages, les fameux 200 facteurs de classement.

Un exemple pour comprendre la relation : la recherche en tant que bibliothèque

C'est là qu'intervient la similitude susmentionnée avec une bibliothèque, où le gestionnaire "doit déterminer le contenu des différents livres afin de donner les bonnes réponses aux personnes qui demandent à les emprunter". Pour ce faire, il consulte le catalogue de tous les volumes présents et lit l'index des livres individuels".

Le catalogue est donc l'index Google créé par les balayages de Googlebot, puis "quelqu'un d'autre" utilise ces informations pour prendre des décisions réfléchies et présenter aux utilisateurs le contenu dont ils ont besoin (le livre qu'ils veulent lire, pour continuer l'analogie donnée).

Lorsqu'une personne demande au bibliothécaire "quel est le meilleur livre pour apprendre à faire des tartes aux pommes très rapidement", le bibliothécaire doit pouvoir répondre de manière appropriée en étudiant les index des différents livres qui parlent de cuisine, mais aussi savoir quels sont les plus populaires. Ainsi, dans le domaine du Web, nous avons l'index fourni par Googlebot et la "deuxième partie", la classification, qui se base sur un système sophistiqué qui étudie l'interaction entre les contenus présents afin de décider quels "livres" recommander à ceux qui demandent des informations.

Une explication simple et non technique de la numérisation

Splitt est revenu plus tard pour clarifier l'analogie sur le fonctionnement de Googlebot, et un article de SearchEngineLand cite ses propos pour expliquer de manière non technique le processus d'exploration du crawler de Google.

"Vous écrivez un nouveau livre et le bibliothécaire doit prendre le livre, déterminer de quoi il s'agit et à quoi il se rapporte, s'il y a d'autres livres qui pourraient avoir été la source ou être référencés par ce livre", a déclaré le Googler. Dans son exemple, le bibliothécaire est le robot d'exploration du Web de Google, c'est-à-dire Googlebot, tandis que le livre est un site ou une page Web.

En simplifiant, le processus d'indexation fonctionne comme suit : "Vous devez lire [le livre], vous devez comprendre de quoi il s'agit, vous devez comprendre comment il se rapporte à d'autres livres, et ensuite vous pouvez le commander dans le catalogue". Ainsi, le contenu de la page web est stocké dans le "catalogue", qui, par métaphore, représente l'index du moteur de recherche, à partir duquel il peut être trié et publié en tant que résultat pour les requêtes pertinentes.

En termes techniques, cela signifie que Google dispose "d'une liste d'URL et que nous prenons chacune de ces URL, que nous leur adressons une requête réseau, que nous regardons la réponse du serveur et que nous la rendons (en gros, nous l'ouvrons dans un navigateur pour exécuter JavaScript) ; nous regardons ensuite à nouveau le contenu et le plaçons dans l'index où il doit être, comme le fait le bibliothécaire".

Quand Googlebot explore-t-il un site ?

Après cette discussion théorique, la vidéo aborde des questions plus techniques liées au robot de Mountain View, et en particulier Splitt explique comment et quand un site est exploré par Googlebot : "Dans la première phase d'exploration, nous arrivons sur votre page parce que nous avons trouvé un lien sur un autre site, parce que vous avez soumis un plan de site ou parce que vous avez été entré d'une manière ou d'une autre dans notre système. Un exemple est l'utilisation de la Search Console pour signaler le site à Google, une méthode qui donne au robot un indice et un déclencheur.

À quelle fréquence Googlebot explore-t-il les sites ?

Splitt commence par dire que le robot essaie de comprendre si, parmi les ressources déjà présentes dans l'index, il y a quelque chose qui doit être vérifié plus souvent. En d'autres termes, s'agit-il d'un site proposant des actualités qui changent tous les jours, d'un site de commerce électronique proposant des offres qui changent tous les 15 jours, ou même d'un site dont le contenu ne change pas parce qu'il s'agit d'un site de musée qui est rarement mis à jour (peut-être pour des expositions temporaires) ?

Googlebot sépare les données de l'index en une section appelée "quotidienne ou fraîche", qui est initialement explorée de manière assidue, puis dont la fréquence diminue au fil du temps. Si Google remarque que le site est "super spammy ou super cassé", Googlebot peut ne pas scanner le site, tout comme les règles imposées au site éloignent le robot.

Comment fonctionne l’analyse de Google

La vidéo ajoute également que Googlebot ne se contente pas d'analyser toutes les pages d'un site en même temps, soit en raison de limitations des ressources internes, soit pour éviter de surcharger le service du site.

Google essaie donc de déterminer jusqu'où il peut aller dans l'exploration, combien de ressources propres il a à sa disposition et dans quelle mesure il peut stresser le site, en déterminant ce que l'on appelle souvent un budget d'exploration et qui est souvent difficile à déterminer. "Ce que nous faisons", ajoute Splitt, "c'est lancer un crawl pendant un certain temps, augmenter le niveau d'intensité et lorsque nous commençons à voir des erreurs, réduire la charge.

Mon site est-il visité par Googlebot ?

Il s'agit de la partie "crawler" de l'araignée de Google, qui est suivie par d'autres activités techniques plus spécifiques telles que le rendu ; pour les sites, cependant, il peut être important de savoir comment dire si un site est visité par Googlebot, et Martin Splitt explique comment le faire.

Google utilise un navigateur en deux étapes (rampement et rendu réel), et à ces deux moments, il présente aux sites une requête avec un en-tête d'agent utilisateur, ce qui laisse des traces bien visibles dans les journaux des référents. Comme nous l'avons lu dans les documents officiels de Mountain View, Google utilise une dizaine de jetons d'agent utilisateur, qui sont responsables d'une partie spécifique du crawling (par exemple, AdsBot-Google-Mobile vérifie la qualité des annonces sur la page web Android).

Les sites peuvent choisir d'offrir aux robots d'exploration une version non complète des pages, mais un HTML pré-visualisé spécifiquement pour faciliter l'exploration : c'est ce qu'on appelle le rendu dynamique, qui signifie en pratique avoir un contenu affiché côté client et un contenu pré-visualisé pour des agents utilisateurs spécifiques, comme indiqué dans les guides de Google. Le rendu dynamique ou dynamic rendering est particulièrement recommandé pour les sites dont le contenu est généré par JavaScript, qui reste difficile à traiter pour de nombreux crawlers, et fournit aux agents utilisateurs un contenu adapté à leurs capacités, comme une version HTML statique de la page.

L'épisode de SEO Mythbusting s'intéresse ensuite à un sujet brûlant, à savoir la navigation mobile. Plus précisément, Suz Hinton demande des précisions sur la manière dont Google analyse et distingue le contenu des sites mobiles de celui des sites desktop. L'analyste de Big G s'arrête tout d'abord pour expliquer ce qu'est l'index mobile first pour Google, c'est-à-dire la manière dont "nous découvrons votre contenu en utilisant un agent utilisateur mobile et un viewport mobile", ce qui sert au moteur de recherche à s'assurer qu'il sert quelque chose de bien aux personnes naviguant depuis un appareil mobile.

Poursuivant son discours, Martin Splitt s'intéresse également aux concepts connexes de "mobile readiness" ou "mobile friendliness" : pour qu'une page soit "mobile friendly", il faut s'assurer que tous les contenus tiennent dans la zone d'affichage, que les "cibles d'appui" sont suffisamment larges pour éviter les erreurs de pression, que les contenus peuvent être lus sans devoir nécessairement agrandir l'écran, etc.

Tout cela est un indicateur de qualité pour Google, c'est-à-dire l'un des 200 facteurs de classement dont nous avons parlé précédemment, même si, en fin de compte, le conseil que donne l'analyste est d'"offrir un bon contenu à l'utilisateur", car c'est la chose la plus importante pour un site.

Le guide officiel de Googlebot : comment accéder et bloquer un site

Nous avons mentionné qu'au cours du mois de juin, une mise à jour a été apportée à la documentation officielle de Google à Mountain View, en particulier à la section expliquant le fonctionnement du crawler et la manière d'accéder à un site.

Tout d'abord, le guide souligne que Googlebot ne devrait pas accéder à la plupart des sites en moyenne plus d'une fois toutes les quelques secondes, mais que, en raison d'éventuels retards, cette fréquence pourrait être légèrement plus élevée sur de courtes périodes.

Googlebot a été conçu pour être exécuté simultanément par des milliers de machines afin d'améliorer les performances et de suivre le rythme de croissance du Web. En outre, pour réduire l'utilisation de la bande passante, Google fait tourner de nombreux crawlers sur des ordinateurs proches des sites qu'ils sont susceptibles d'analyser. Par conséquent, nos fichiers journaux peuvent indiquer des visites du site google.com provenant de différents ordinateurs, tous dotés de l'agent utilisateur Googlebot. Toutefois, l'objectif de Google est d'analyser le plus grand nombre possible de pages du site à chaque visite sans surcharger la bande passante du serveur et, si le site ne peut pas répondre aux demandes d'analyse de Google, nous pouvons demander à modifier la fréquence d'analyse.

En général, Googlebot analyse les sites en HTTP/1.1. Toutefois, à partir de novembre 2020, Googlebot pourra analyser les sites qui pourraient bénéficier de HTTP/2, s'ils sont pris en charge. Cela permet d'économiser des ressources informatiques (par exemple, CPU, RAM) pour le site et Googlebot, mais n'affecte pas l'indexation ou le classement du site.

Pour désactiver l'analyse sur HTTP/2, nous devons demander au serveur qui héberge le site de répondre par un code d'état HTTP 421 lorsque Googlebot tente d'analyser le site sur HTTP/2. Si cela n'est pas possible, nous pouvons utiliser une solution temporaire et envoyer un message à l'équipe de Googlebot.

Googlebot peut analyser les 15 premiers Mo de contenu d'un fichier HTML ou texte pris en charge. Au-delà de ce seuil, Googlebot arrête de scanner et ne considère toujours que les 15 premiers Mo de contenu pour l'indexation. Plus précisément, la limite de 15 Mo s'applique aux extractions effectuées par Googlebot (Googlebot Smartphone et Googlebot Desktop) lorsqu'il récupère des types de fichiers pris en charge par Google Search ; le contenu suivant est supprimé par Googlebot et seuls les 15 premiers Mo sont transmis pour indexation.

Cette limitation ne s'applique toutefois pas aux ressources telles que les images ou les vidéos, car dans ce cas, Googlebot récupère les vidéos et les images référencées dans le HTML avec une URL (par exemple <img src=”https://example.com/images/puppy.jpg” alt=”cute puppy looking very disappointed” />) séparément avec des récupérations consécutives.

Google et les 15 Mo : ce que signifie la limite

C'est précisément cette référence à 15 Mo, qui est apparue comme mentionnée à la fin du mois de juin 2022, qui a déclenché la réaction de la communauté internationale des référenceurs, obligeant Gary Illyes à rédiger un autre article de blog pour clarifier la question.

Tout d'abord, le seuil des 15 premiers mégaoctets (Mo) que Googlebot "voit" lors de la récupération de certains types de fichiers n'est pas nouveau, mais "existe depuis de nombreuses années" et a été ajouté à la documentation "parce qu'il pourrait être utile à certaines personnes lors du débogage et parce qu'il change rarement".

Cette limitation ne s'applique qu'aux octets (contenu) reçus pour la requête initiale effectuée par Googlebot, et non aux ressources de référence dans la page. Cela signifie, par exemple, que si nous ouvrons https://example.com/puppies.html, notre navigateur téléchargera d'abord les octets du fichier HTML et, sur la base de ces octets, pourra faire d'autres demandes de JavaScript externe, d'images ou de tout autre élément référencé par une URL dans le HTML ; Googlebot fait la même chose.

Pour la plupart des sites, la limite de 15 Mo ne signifie "probablement rien", car il y a très peu de pages sur l'internet qui soient plus grandes que cela et "vous, cher lecteur, avez peu de chances de les posséder, puisque la taille moyenne d'un fichier HTML est environ 500 fois plus petite : 30 kilobytes (kB)". Toutefois, dit Gary, "si vous êtes le propriétaire d'une page HTML qui dépasse 15 Mo, vous pourriez peut-être au moins déplacer certains scripts en ligne et la poussière CSS vers des fichiers externes, s'il vous plaît".

Les URI de données contribuent également à la taille du fichier HTML "parce qu'ils sont dans le fichier HTML".

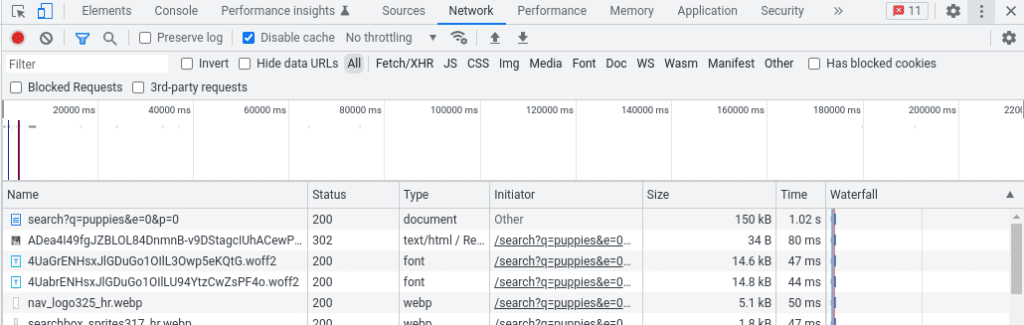

Pour connaître la taille d'une page et savoir ainsi si nous dépassons la limite, il existe plusieurs moyens, mais "le plus simple est probablement d'utiliser le navigateur et ses outils de développement".

En particulier, conseille Illyes, nous devrions charger la page comme nous le ferions normalement, puis lancer les outils de développement et passer à l'onglet Réseau ; en rechargeant la page, nous devrions voir toutes les demandes que le navigateur a dû faire pour rendre la page. La requête principale est celle que nous recherchons, avec la taille en octets de la page dans la colonne Taille.

Dans cet exemple tiré des outils de développement de Chrome, la page pèse 150 kB, ce qui est indiqué dans la colonne taille :

Une alternative possible pour les plus aventureux est d'utiliser cURL à partir d'une ligne de commande, comme indiqué ci-dessous :

boucle \N

-A "Mozilla/5.0 (Windows NT 10.0 ; Win64 ; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/103.0.0 Safari/537.36" \

-so /dev/null https://example.com/puppies.html -w "%{size_download}

Comment empêcher Googlebot de visiter le site

Dans certains cas, on peut être tenté par l'idée d'empêcher Googlebot de visiter le site.

Cependant, selon Google, "il est presque impossible de garder un serveur web secret en ne publiant pas de liens vers celui-ci" : par exemple, dès qu'un utilisateur suit un lien de ce serveur "secret" vers un autre serveur web, l'URL "secrète" pourrait être affichée dans la balise de référence et être stockée et publiée par l'autre serveur web dans son journal de référence. De même, de nombreux liens obsolètes et inaccessibles existent sur le Web. Lorsque quelqu'un publie un mauvais lien vers votre site ou ne met pas à jour les liens pour refléter les modifications apportées à votre serveur, Googlebot essaie de rechercher un mauvais lien sur le site.

En fin de compte, il existe toujours une série d'options pour empêcher Googlebot d'explorer le contenu de votre site - voici par exemple trois façons de cacher un site à Google, mais pas aux utilisateurs - mais Google vous invite à ne pas oublier "la différence entre empêcher Googlebot d'explorer une page, empêcher Googlebot d'indexer une page et l'empêcher complètement d'être explorée par les robots et les utilisateurs".

Vérification de Google : la liste officielle des adresses IP et la recherche inversée de DNS

Cependant, avant de bloquer Googlebot, il y a un autre aspect à ne pas négliger : la chaîne de l'agent utilisateur utilisée par Googlebot est souvent usurpée par d'autres robots d'exploration, il est donc très important de vérifier qu'une requête problématique provient bien de Google.

La meilleure façon de vérifier qu'une requête provient effectivement de Googlebot est d'utiliser une recherche DNS inverse sur l'IP source de la requête, ou de faire correspondre l'IP source avec les plages d'adresses IP de Googlebot, que Google a décidé de rendre publiques en novembre 2021 en réponse aux demandes de la communauté.