Prêt pour la mise à jour de l’expérience des pages ? Tout ce que vous devez savoir

L'utilisateur et son expérience au centre du référencement, ou du moins en bonne place, aux côtés du contenu et des autres aspects qui déterminent le classement des pages sur Google : la mise à jour de l'expérience des pages, la mise à jour algorithmique avec laquelle Google introduit comme facteur de classement une série d'éléments techniques évaluant la performance des pages du site par rapport à l'expérience offerte aux utilisateurs, a commencé aujourd'hui. Essayons de faire un récapitulatif général sur cette importante mise à jour et sur les méthodes de calcul des scores métriques (où il y a quelques nouveautés).

La longue attente de la nouvelle mise à jour des facteurs de classement

Nous l'attendions depuis plus d'un an, depuis que Google a présenté le nouvel ensemble de mesures qu'il utiliserait pour calculer les performances des pages Web ayant une incidence sur la qualité de l'expérience utilisateur, que nous avons appris par la suite à appeler Core Web Vitals ou Essential Web Signals. Toujours en 2020, nous avons ensuite découvert que ces mesures deviendraient un facteur de classement, au même titre que d'autres éléments techniques, dans le cadre de ce que l'on a appelé la mise à jour Google Page Experience Update, initialement prévue pour mai 2021, puis glissée à la mi-juin.

Et c'est précisément là que nous sommes, maintenant, prêts à voir les effets concrets de cette "révolution algorithmique" en termes de changements de classement pour nos projets, en sachant que, par choix précis du moteur de recherche, l'expérience de la page ne sera pas complètement intégrée dans les systèmes de classement de Google avant la fin du mois d'août. Cette mise à jour concerne les appareils mobiles, tandis que celle des pages de bureau devrait être lancée avant la fin de l'année.

Le paysage Web actuel est toujours à la traîne sur ces questions : une étude récente menée par Conductor et Digital Marketing Depot révèle que seuls 13 % des sites analysés dans trois secteurs clés tels que la vente au détail, la technologie et la finance/assurance répondent aux critères des Core Web Vitals.

Introduction à la mise à jour de l’expérience des pages

Il peut être utile, à ce stade, de résumer ce qu'est réellement la mise à jour de l'expérience des pages dans les résultats de recherche de Google (traduction des pages d'assistance officielles de Big G), en se référant aux indications de Patrick Kettner, Developer Advocate de la société, qui dans une nouvelle série de vidéos sur la chaîne YouTube Google Search Central nous donne un aperçu complet du sujet.

Le premier épisode se concentre naturellement sur les définitions : la mise à jour de l'expérience des pages est "une nouvelle donnée de classement pour la recherche Google", qui évalue "la qualité de l'expérience vécue par les utilisateurs sur chaque page du Web". Google a "toujours dit que l'expérience utilisateur est essentielle pour le classement des recherches" et maintenant, "grâce aux progrès des capacités des navigateurs, nous pouvons en toute confiance faire figurer n'importe quel contenu dans le carrousel des meilleures histoires et dans les résultats de recherche normaux", et les développeurs et propriétaires de sites ont des références techniques précises à suivre pour proposer des pages conformes aux normes.

Des mesures objectives pour évaluer les performances

L'un des aspects les plus pertinents de cette mise à jour est que, jusqu'à présent, "le concept de performance web a toujours été subjectif" : ce qui est rapide sur mon ordinateur, dit Kettner, "peut être inacceptablement lent pour les personnes qui utilisent le site".

Au lieu de cela, l'expérience de la page "nous permet de nous concentrer sur ces personnes et de nous assurer qu'elles font réellement l'expérience du site d'une manière qui nous satisfait". En pratique, elle "fixe un objectif de base que les équipes peuvent atteindre au cours du développement pour s'assurer que les utilisateurs bénéficient d'une excellente expérience utilisateur".

Ce qui est nouveau, c'est que cette mise à jour examine et mesure l'expérience de l'utilisateur lui-même : les mesures qui composent l'expérience de la page "sont, en partie, recueillies à partir du rapport sur l'expérience de l'utilisateur de Chrome, un ensemble de données publiques qui montre avec quelle rapidité ou non des millions d'URL sur Internet ont été chargées et se sont comportées sur les appareils réels de personnes réelles".

Quels sont les paramètres qui composent le facteur de classement "Expérience de la page" ?

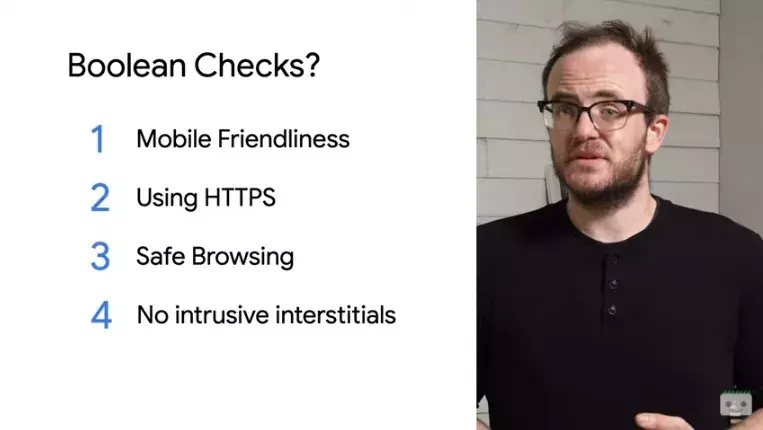

Au sein de ce facteur de classement complexe, il existe en fait deux groupes différents de mesures.

Le premier est constitué d'éléments définis comme des "valeurs booléennes", c'est-à-dire des "choses que vous avez ou que vous n'avez pas" : convivialité pour les mobiles, pages avec protocole HTTPS, navigation sécurisée, absence de publicités interstitielles intrusives.

Le deuxième groupe contient des "mesures qui évaluent votre page en fonction de l'expérience de vos utilisateurs réels sur leurs appareils réels", ou Core Web Vitals, défini comme "une liste, mise à jour annuellement, de mesures qui définissent ce qu'il faut pour avoir cette excellente expérience utilisateur dont nous parlons". Actuellement, comme nous le savons, les trois premières vitales du Web identifiées par Google sont le First Input Delay, le Largest Contentful Paint et le Cumulative Layout Shift.

Le sens de l'expérience de la page

En conclusion, Kettner explique que l'expérience de la page "consiste à faire en sorte que vos utilisateurs obtiennent ce qu'ils veulent de la meilleure façon possible" : elle propose des données et des rapports adaptés à de véritables utilisateurs de pages, et met ainsi en évidence les aspects concrets et problématiques que nous pouvons améliorer.

Il faut toutefois comprendre un aspect important : l'expérience de la page "concerne ce que l'utilisateur vit réellement et n'est pas quelque chose qui s'applique à l'ensemble de votre site web" ; chaque utilisateur utilise le site différemment, tandis que chaque URL est examinée individuellement.

Pour clarifier ce point, M. Kettner invite les internautes à consulter le rapport sur l'expérience des pages dans la Search Console, qui "donne un aperçu impressionnant des parties du site qui doivent être améliorées" : par exemple, la page d'accueil "peut donner des résultats fantastiques, mais vos pages de contenu ne sont peut-être pas idéales". Et cela peut conduire à un classement élevé de la page d'accueil, alors que les autres pages restent à la traîne.

Mais "la bonne nouvelle, c'est que rien de tout cela n'est une boîte noire : toutes les vitales du Web sont extraites chaque mois du rapport sur l'expérience des utilisateurs de Chrome", de sorte que chacun peut les contrôler et les vérifier.

Google met à jour ses outils pour mesurer les Core Web Vitals

La mise à jour de l'expérience des pages est conçue pour mettre en avant les pages qui offrent une excellente expérience utilisateur, mais cette attente n'est encore " que " l'un des nombreux facteurs pris en compte par les systèmes de Google : traduit en d'autres termes, il n'est pas certain que la mise à jour entraînera réellement des changements dans les classements et, de plus, étant donné sa mise en œuvre progressive, il se peut qu'il n'y ait pas de chocs immédiats et que Google puisse encore surveiller tout problème imprévu ou indésirable.

La nature progressive de cette mise à jour est également évidente du fait que, juste au cours des dernières semaines, Google a mis à jour certaines des méthodes par lesquelles il mesure ces paramètres afin d'inclure des formules affinées en réponse à des procès intentés par des développeurs dans ce domaine.

L'article de Detlef Johnson dans Search Engine Land nous aide à naviguer dans ce scénario complexe, en expliquant comment utiliser les données de laboratoire et les données de terrain pour optimiser l'expérience de la page.

Comment fonctionnent les mesures de Core Web Vitals

Les "Core Web Vitals" sont des mesures de performance liées à la vitesse qui déterminent la réalisation d'une "expérience stable, visualisable et utilisable pour une fenêtre d'affichage d'un dispositif donné, y compris le contenu hors écran jusqu'à 9000 pixels verticaux".

Plus vite, c'est mieux, comme il est facile de le deviner, et par conséquent, des métriques plus faibles sont généralement meilleures.

Les données de terrain, qui sont prises en compte pour le classement, varient en fonction de la puissance de l'appareil de l'utilisateur réel, de la taille de l'écran et de la connectivité du réseau. Les données de laboratoire ont des valeurs par défaut pour celles-ci et, sauf dans le cas de Page Speed Insights, peuvent être calibrées par les développeurs pour simuler tous les types de conditions ; ces données de laboratoire ne sont pas prises en compte pour les classements.

Changements apportés à First Contentful Paint

Bien qu'ils ne figurent pas officiellement parmi les trois principaux CWV, les composants de First Contentful Paint (FCP) contribuent toujours aux signaux essentiels du web : récemment, le seuil pour un "bon" score est passé de 1,0 à 1,8 seconde.

Le FCP prend en compte le temps jusqu'au premier octet (qui reflète davantage le temps de réponse du serveur que quelque chose qui peut être manipulé directement avec du code) et le temps nécessaire pour traiter les ressources bloquant le rendu telles que les CSS.

Modifications apportées au Largest Contentful Paint

De petits changements sont également intervenus en ce qui concerne le Largest Contentful Paint le plus important, qui est "une étape importante dans le cycle de vie d'une page" : à l'origine, la mesure n'incluait pas certains éléments hors écran, alors qu'elle détecte désormais l'élément le plus grand, même s'il a ensuite été retiré du DOM de la page une fois découvert, ou lorsque plusieurs images de même taille sont qualifiées.

Ces situations se produisent lorsque les carrousels chargent et mettent en cache le contenu des diapositives hors écran.

Un autre changement utile est que LCP ignore désormais les images d'arrière-plan.

Modifications du Cumulative Layout Shift

Enfin, une nouveauté pour le CLS : pour éviter que des situations telles que des sessions de navigation extrêmement longues ne compromettent les résultats de cette mesure, les plus petites sessions "fenêtre" sont limitées à 5 secondes, marquées comme terminées par un intervalle d'une seconde comme limite pour trouver les 5 pires secondes de décalage de la mise en page.

Cela semble être une "bien meilleure représentation du changement que le comptage de sessions totalement non couvertes qui peuvent durer 20 minutes ou plus et donner des scores exagérés et hors de proportion.

L'utilité des données de PageSpeed Insights

Selon M. Johnson, l'astuce pour optimiser les pages pour Core Web Vitals consiste à "apprendre plus d'une façon officielle de récupérer les scores, ce qui devient encore plus compliqué par la façon dont vous pensez aux données que vous visualisez".

Même Page Speed Insights, souvent la première référence pour les professionnels du référencement, ne fournit pas à lui seul suffisamment d'informations pour "raconter toute l'histoire" : l'outil est en fait conçu pour "fournir un instantané complet permettant aux développeurs de résoudre les problèmes de performance" ; lorsqu'elles sont disponibles auprès de CrUX, les données de terrain agrégées sur une période antérieure de 4 semaines sont utiles pour établir des comparaisons, mais l'apparence des données de laboratoire et de terrain montrera sans aucun doute une différence entre les deux rapports.

La variance est en fait "un phénomène naturel entre les sessions de test et lors de la comparaison des tests de différents appareils et/ou réseaux" : les données de terrain varient donc autant que l'audience d'un site web donné. Par conséquent, les données de terrain de l'ISP "représentent une gamme de données, agrégées sur les 28 jours précédents, jusqu'à la valeur de la journée complète la plus récente".

Quand faut-il s'attendre à des changements de classement (et quelles plages horaires seront examinées) ?

L'auteur indique ensuite que le facteur de classement Expérience de la page "pourrait vraisemblablement s'appuyer sur les mêmes scores agrégés des 28 jours précédents", mais cela est peu probable, "car il serait beaucoup plus performant s'il était plutôt basé sur l'ensemble de données BigQuery agrégées préparées pour 28 jours du mois précédent".

Cela signifie donc que "toute modification du classement prendra effet le deuxième mardi de chaque nouveau mois".

Ainsi, les données BigQuery destinées aux rapports CrUX seraient "soumises à un processus d'optimisation des performances qui prépare les données du mois précédent pour la consommation publique". Pour l'instant, cette indexation, et éventuellement la mise en cache de certaines réponses aux requêtes, permet aux "utilisateurs de CrUX d'effectuer des requêtes historiques remontant à la fin de 2017, date à laquelle les données ont été collectées pour la première fois".

La différence pratique entre les données de laboratoire et les données de terrain

M. Johnson approfondit le sujet complexe de la différence entre les données de laboratoire et les données de terrain, en soulignant que les scores de Lighthouse Lab dans l'ISP sont "calibrés pour être représentatifs de vos percentiles supérieurs" pour les scénarios les plus défavorables, tels que des navigateurs peu puissants sur des réseaux lents. Avec ce choix, Google s'assure intentionnellement que les développeurs disposent d'un retour d'information plus riche pour résoudre plus facilement les problèmes qui peuvent survenir, même si ces situations sont moins courantes dans le monde réel.

Si les résultats des laboratoires étaient "indicatifs de conditions plus moyennes, ils ne révéleraient pas les goulets d'étranglement en matière de performances que les développeurs doivent voir afin d'apporter des changements pour améliorer l'expérience de la page dans des conditions de stress.

En revanche, les données de terrain fournissent des exemples d'utilisation réelle, et plus précisément "sont indicatives de l'audience enregistrée par les navigateurs avec une utilisation réelle de votre site web". Ils sont importants "parce que c'est ce que Google utilise pour classer l'expérience de la page".

Presque toujours, les scores des données de terrain seront meilleurs que ceux des données de laboratoire pour la même page. En outre, les données de terrain peuvent "rester stables dans le temps une fois préparées pour être archivées à long terme, avec des données récentes préparées sur une base mensuelle, alors que les données de laboratoire peuvent différer à chaque nouveau test".

Lorsque les navigateurs ont les autorisations nécessaires pour transmettre les scores, les données de terrain sont envoyées et collectées pour être utilisées par PSI, tout outil Core Web Vitals utilisant l'API CrUX ouverte, ou pour ceux qui écrivent le JavaScript Core Web Vitals dans les pages web. La seule façon d'examiner les données du champ en temps réel est de "choisir d'écrire le code JavaScript et de le collecter pour votre propre usage dans une console ou un dépôt de navigateur, ou de l'envoyer à Google Analytics".

Utilisation des données de laboratoire pour l'optimisation

Le projet open source Lighthouse alimente les données de laboratoire, a été mis en œuvre dans Dev Tools et peut également être installé dans un paquet fourni avec son propre interpréteur de ligne de commande (CLI). Dans Dev Tools, Lighthouse peut être configuré pour correspondre à une puissance et à une vitesse réduites ou accrues par rapport au paramètre par défaut du "percentile supérieur". Concrètement, nous pourrions simuler une puissance et une vitesse variables, par exemple si nous avons les moyens de fournir des expériences plus élaborées à certains seuils simulés, en mettant en œuvre une stratégie d'amélioration progressive.

Considérations finales

En fin de compte, nous devrions nous intéresser de près au dépannage et à l'amélioration des facteurs de performance qui influencent l'expérience de la page, même si nous ne sommes pas des développeurs ou si nous ne nous préoccupons pas du référencement naturel, car ces éléments "sont incroyablement importants pour la façon dont nos pages et nos applications de rendu de page, y compris les applications natives avec WebView, sont vécues par les utilisateurs réels sur le terrain.

Trop souvent, une application qui fait l'objet d'une utilisation intensive entraîne d'innombrables heures de frustration et peut avoir un impact négatif sur les résultats : par exemple, Detlef Johnson raconte une expérience personnelle avec "des applications natives du NYTimes sur des écrans de la taille d'un smartphone, qui chargent le contenu et les scripts lentement, même dans les meilleures conditions de réseau. Cela entraîne des retards dans le défilement et le clic, même après qu'un article principal a été rendu dans la fenêtre ; de plus, "il peut être vraiment affreux de naviguer dans des changements continus de mise en page lorsque les publicités sont chargées à des moments différés".

Google dispose de nombreuses études de cas montrant l'effet positif sur le chiffre d'affaires généré par la mise en œuvre de corrections des performances, ce qui conduit à des expériences plus positives. Revenant sur l'exemple du célèbre journal, Johnson conclut que "sans la valeur du contenu du NYTimes, son application pourrait être davantage tournée en dérision et être beaucoup moins utilisée qu'elle ne l'est actuellement".